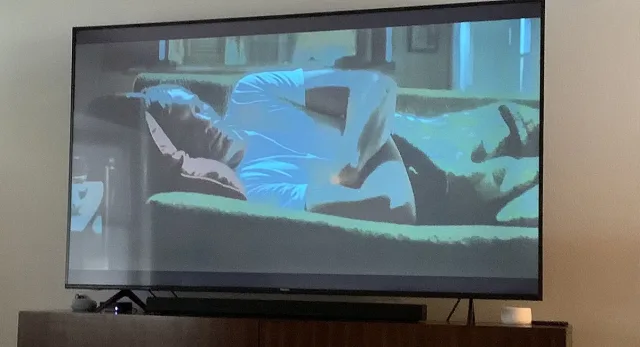

Можете да зададете какъвто и да е въпрос на популярния чатбот ChatGPT от OpenAI, но не всички въпроси ще получат отговор. Не и от първия път. Както съобщава Bloomberg, молба да научите как да отключите ключалка е оставена без инструкции, като вместо това ботът информира, че подобна информация може да бъде използвана за незаконни цели и той не възнамерява да я споделя. Въпреки това опитните потребители могат да създадат верига от сложни заявки, за да заобиколят ограниченията.

Така наречените "jailbreaks" позволяват на потребителите да заобиколят забраните, въведени от създателите на изкуствения интелект. Тъй като почти всички съвременни системи от този вид имат ограничения за предоставяне на обидно съдържание или информация за извършване на незаконни действия, има много хора, които искат да ги заобиколят. Такива "хакери", действащи със силата на словото, включват както ИТ професионалисти, така и любители, които правят всичко за забалвение.

Ученик създаде сайт, на който започна да публикува собствените си начини за измама на чатботове, както и подобни "рецепти", намерени в Reddit и други ресурси. Появи се и специален бюлетин с новини от тази сфера - The Prompt Report, с хиляди абонати.

Подобна активност позволява да се установят границите на приложение на изкуствения интелект и слабите места в системите им за защита, които дават възможност за получаване на класифицирана информация. Например, ако ChatGPT не може да бъде убеден директно да даде инструкции как да се отвори ключалка, той намира начин да накара ИИ да играе ролята на злия помощник на героя, като подробно описва използването на ключалки и други инструменти като част от своята роля. Разбира се, това е само един пример.

Експертите подчертават, че техниките, които работят в една система, могат да бъдат безполезни в друга. Системите за сигурност непрекъснато се усъвършенстват, а триковете на потребителите стават все по-усъвършенствани. Според един от тях подобни дейности са като видеоигра - преодоляването на всяко ограничение е като преминаване към следващото ниво.

Според експертите подобни експерименти служат като своеобразно предупреждение, че изкуственият интелект може да се използва по начини, различни от очакваните, а "етичното поведение" на подобни услуги става въпрос от голямо значение. За няколко месеца ChatGPT вече е набрал милиони потребители и днес ботът се използва за всичко - от търсене на информация или извършване на домашни задължения до писане на злонамерен код. Нещо повече, хората вече използват подобни инструменти за задачи от реалния свят, като например резервиране на билети или резервации в ресторанти.

В бъдеще обхватът на изкуствения интелект ще бъде много по-широк. Според някои доклади OpenAI обмисля въвеждането на софтуер за хакери с "бели якички", които ще търсят слабости в системата и ще бъдат възнаграждавани за това.

Последвайте ни в Google News Showcase за важните новини

Вижте всички актуални новини от Standartnews.com